Translated, scaleup italiana che opera nell’ambito delle soluzioni linguistiche basate sull’intelligenza artificiale, rafforza il posizionamento di Lara, il suo modello di IA per la traduzione attraverso la sinergica collaborazione con Lenovo e le sue tecnologie per il calcolo ad alte prestazioni. Progettata per ambienti produttivi ad alto volume, Lara offre oggi quello che prima richiedeva un compromesso: unire la fluidità e le capacità di ragionamento di un grande modello linguistico alla precisione e affidabilità della traduzione automatica, garantendo prestazioni in tempo quasi istantaneo.

Per raggiungere questo risultato, Translated ha co-progettando insieme a Lenovo una soluzione hardware dedicata alla traduzione e sviluppando un sistema di decodifica innovativo per sfruttare al massimo le prestazioni dei processori di ultima generazione. Ottimizzata per contesti critici in termini di latenza, come chat in tempo reale, trading e notizie, Lara oggi raggiunge una latenza inferiore al secondo nelle 50 lingue più parlate al mondo. È un’innovazione che fissa un nuovo standard per traduzioni di alta qualità e bassa latenza, aprendo la strada a soluzioni economicamente più efficienti, come la traduzione immediata della sola parte di contenuto necessaria, elaborando il resto solo su richiesta. Nella traduzione, Lara è ora da 10 a 40 volte più veloce dei principali modelli linguistici (LLM), offrendo allo stesso tempo una qualità superiore che la rende perfetta per i moderni flussi di lavoro aziendali.

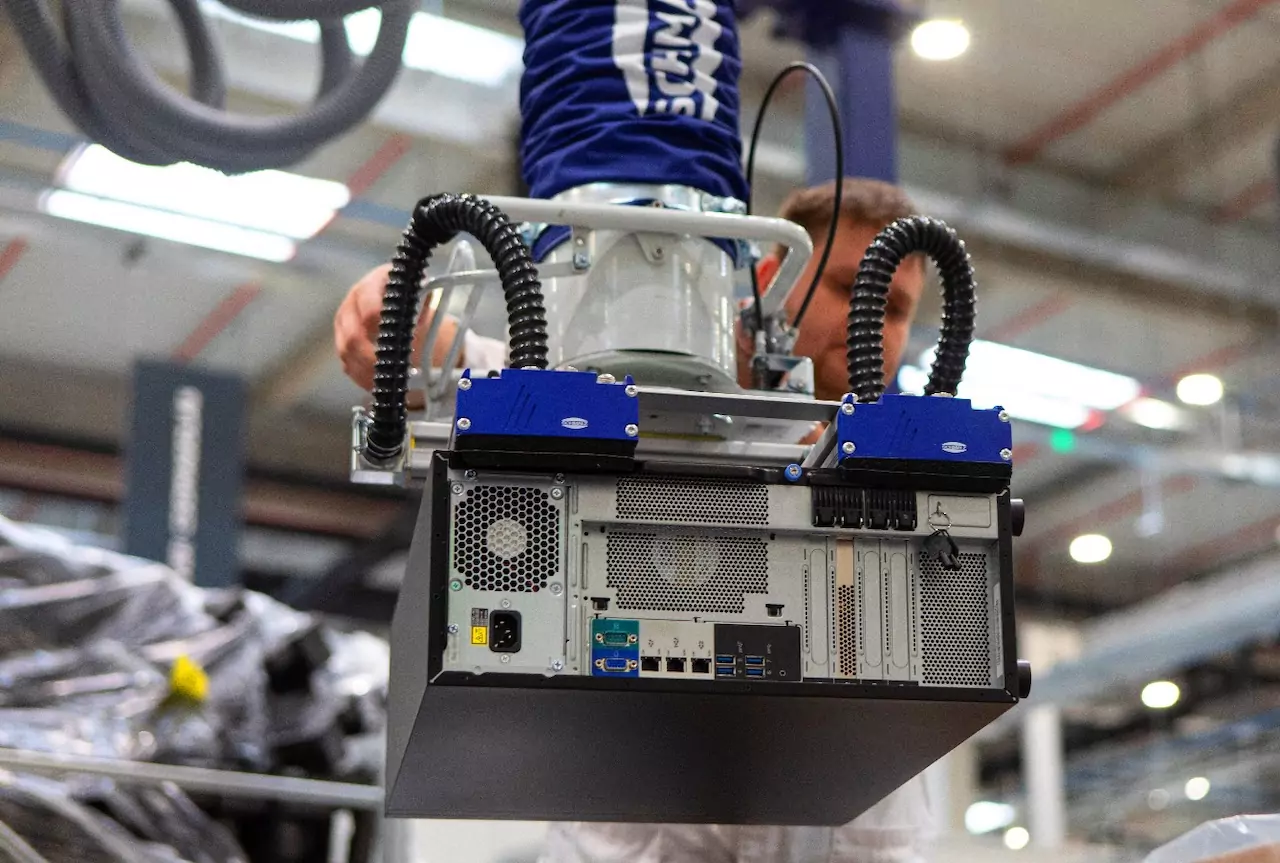

Per raggiungere queste prestazioni, Lenovo ha fornito i server ThinkSystem basati sulle GPU di NVIDIA, i processori più avanzati al mondo per i carichi di lavoro dell’IA. Ogni server supporta otto delle più recenti GPU interconnesse e ad alta velocità, che alimentano i progressi dell’IA, tra cui i large language model, il machine learning, il training dei modelli e il computing ad alte prestazioni. Grazie a un intenso lavoro di progettazione congiunta, Translated e Lenovo sono riuscite a ottimizzare l’architettura per la traduzione. I server ThinkSystem sono stati installati in due data center a Washington e in California, strategicamente posizionati vicino ai principali hub internet per mantenere la latenza della rete tra Lara e le principali dorsali di rete sotto al millisecondo.

Per migliorare ulteriormente la reattività del sistema, il team di ingegneri di Translated ha progettato una nuova architettura, inedita nel settore della traduzione. Questo sistema coniuga i punti di forza della traduzione automatica tradizionale con quelli dell’IA generativa. Un approccio unico che consente di generare traduzioni parallele e contestualizzate, accelerando significativamente i tempi di risposta senza compromettere la qualità.

“L’IA funziona solo quando risolve problemi in contesti reali, con la velocità necessaria a supportare il business su larga scala. Abbiamo raggiunto questo traguardo grazie a un partner che ha lavorato con noi nello stesso modo in cui lavoriamo con i nostri clienti: condividendo obiettivi, coinvolti al massimo e puntando a generare un impatto a lungo termine. Questo è il tipo di collaborazione che rende possibile l’innovazione”, afferma in una nota Marco Trombetti, CEO di Translated.

“La nostra tecnologia avanzata, coniugata con la visione di Translated, ha permesso di raggiungere una velocità e una qualità senza precedenti nel settore linguistico – dice Alessandro de Bartolo, general manager, Italia, Infrastructure solution group di Lenovo – Le soluzioni ThinkSystem di Lenovo rappresentano l’ultima frontiera in termini di prestazioni dell’IA, offrendo un’infrastruttura potente e affidabile per applicazioni mission-critical. Questa partnership è un esempio di come l’IA possa trasformare il modo in cui le persone comunicano a livello globale, offrendo traduzioni più rapide e accurate per un mondo sempre più connesso”.

Nell’ambito della loro collaborazione a lungo termine, le due aziende hanno anche siglato un accordo per implementare sistemi di raffreddamento a liquido in tutte le infrastrutture di Translated. Questo permetterà di ridurre il consumo di energia e aumentare la densità delle macchine, a supporto di operazioni di IA più sostenibili e facilmente scalabili.

© RIPRODUZIONE RISERVATA